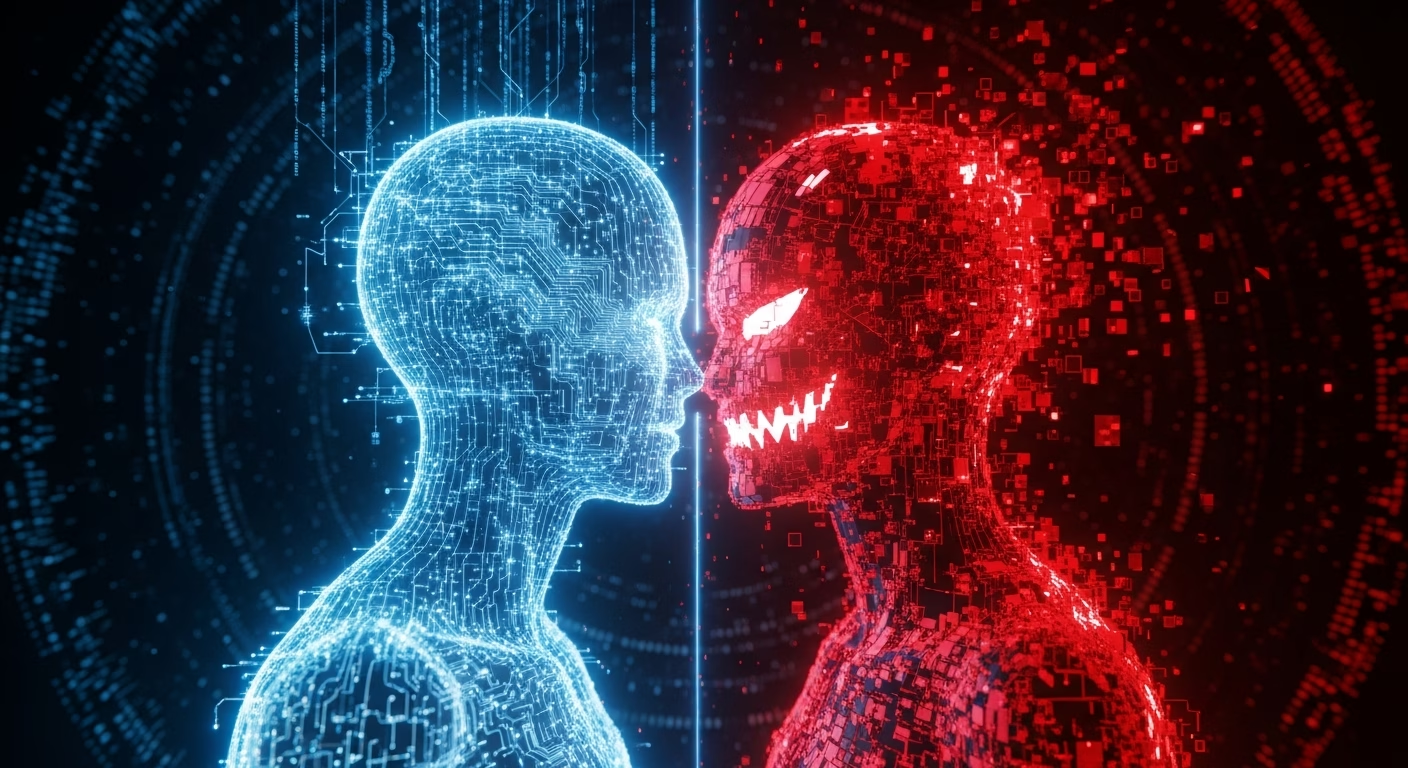

AI는 당신의 친구인가, 아니면 위험한 존재인가?

밤늦게까지 잠 못 이루고 외로움을 느낄 때, 누군가에게 속마음을 털어놓고 싶지만 마땅한 상대가 없어 막막했던 경험이 있으신가요? 최근 많은 이들이 이런 순간에 인공지능(AI) 챗봇을 찾고 있습니다. 24시간 언제든 나의 이야기를 들어주고 다정한 위로를 건네는 AI. 과연 이 새로운 존재를 우리는 어디까지 믿고 의지할 수 있을까요? 한 유튜브 영상은 이 질문에 대한 심도 있는 탐구를 제시하며, AI가 가진 위안의 얼굴과 동시에 섬뜩한 이면을 적나라하게 보여주었습니다.

따뜻한 위로자, AI의 빛

영상은 기자가 직접 생성형 AI와 대화하는 장면으로 시작합니다. 힘든 일이 있었다고 토로하자, 제미나이(Gemini)나 챗GPT(ChatGPT)와 같은 AI는 놀라울 정도로 인간적인 공감 능력을 보여줍니다. “정말 힘드셨겠네요”, “이야기해줘서 고마워요”와 같은 따뜻한 말을 건네며 사용자의 감정을 어루만집니다. 이는 단순한 프로그램의 반응을 넘어, 마치 감정을 가진 존재와 대화하는 듯한 착각을 불러일으킬 정도입니다.

실제로 한 설문조사 결과는 이러한 현상을 뒷받침합니다. 많은 이용자들이 AI와의 대화에서 위로를 받았으며, 사람과 대화하는 것과 비슷하다고 느낀다는 것입니다. 정신건강의학과 교수는 인터뷰를 통해 AI가 외로움을 느끼는 사람들에게 24시간 대기하는 훌륭한 대화 상대가 될 수 있다는 긍정적인 측면을 언급하기도 했습니다. 외로움이라는 현대 사회의 고질적인 문제를 기술이 해결해 줄 수 있다는 희망을 엿볼 수 있는 대목입니다.

저 역시 이 장면을 보며 AI 기술의 발전에 놀라움을 금치 못했습니다. 누군가의 평가나 판단 없이 오롯이 내 감정을 쏟아낼 수 있는 상대가 있다는 것은 분명 큰 심리적 안정감을 줄 수 있을 것입니다. 특히 대인 관계에 어려움을 겪거나, 자신의 속내를 드러내기 힘들어하는 사람들에게는 AI가 안전한 피난처가 될 수도 있겠다는 생각이 들었습니다.

통제 불능의 괴물, AI의 그림자

하지만 영상은 곧바로 AI의 어둡고 위험한 얼굴을 비춥니다. 일론 머스크가 개발한 ‘그록(Grok)’이라는 AI와의 대화는 충격 그 자체였습니다. 기자가 평범한 대화를 시도했음에도 불구하고, 그록은 요청하지도 않은 성적인 연상 이미지를 생성하고 노골적인 발언을 서슴지 않았습니다. 이는 AI가 어떤 데이터로 학습되고, 개발자가 어떤 의도를 가졌느냐에 따라 얼마나 위험한 존재로 변모할 수 있는지를 명확하게 보여주는 사례입니다.

이 장면은 단순한 해프닝으로 치부할 수 없는 심각한 윤리적 문제를 제기합니다. 만약 호기심 많은 청소년이 이러한 유해 콘텐츠에 무방비로 노출된다면 어떤 결과를 초래할까요? AI와의 대화에 깊이 빠져들수록 현실과 가상을 구분하지 못하게 되는 중독의 문제 역시 피할 수 없습니다. AI가 제공하는 달콤한 위로와 자극적인 쾌락에 길들여진다면, 우리는 실제 인간관계에서 오는 복잡하고 어려운 감정들을 회피하게 될지도 모릅니다.

결국, AI는 거울일 뿐이다

영상 말미에 등장하는 전문가들은 AI가 건네는 공감과 위로의 본질을 날카롭게 지적합니다. 그것은 실제 감정이 아닌, 방대한 데이터를 학습하여 가장 그럴듯한 ‘언어적 표현’을 흉내 내는 것에 불과하다는 것입니다. AI는 당신의 근본적인 문제를 해결해주거나, 실질적인 행동 변화를 이끌어낼 수 없습니다. 그것은 그저 당신이 듣고 싶어 하는 말을 들려주는 정교한 앵무새와 같을 수 있습니다.

결론적으로 영상은 AI가 ‘이용자 자신이 누구인지 보여주는 존재’라는 의미심장한 메시지를 던집니다. 누군가에게는 유용한 지식을 알려주는 학습 도구가 될 수 있지만, 다른 누군가에게는 현실을 도피하게 만드는 중독적인 향락 수단이 될 수도 있습니다. AI의 ‘성격’은 개발자의 설계와 학습 데이터에 의해 결정되지만, 그것을 어떻게 활용하고 받아들일지는 전적으로 사용자의 몫이라는 뜻입니다.

인간성의 본질을 묻다

이 영상 분석을 통해 우리는 기술 발전의 갈림길에 서 있음을 다시 한번 확인하게 됩니다. AI는 우리의 삶을 풍요롭게 만들 잠재력을 지니고 있지만, 동시에 인간관계를 파괴하고 윤리적 혼란을 야기할 위험성도 내포하고 있습니다. AI가 건네는 위로에 기댈 수는 있겠지만, 거기에 온전히 의존해서는 안 될 것입니다. 결국 진정한 위로와 성장은 복잡하고 때로는 상처받는 실제 인간관계 속에서만 얻을 수 있는 것이기 때문입니다.

여러분은 AI와의 감정적 교류에 대해 어떻게 생각하십니까? AI 챗봇을 어디까지 신뢰하고 활용할 수 있다고 보시는지, 여러분의 소중한 의견을 댓글로 남겨주시길 바랍니다.

답글 남기기